Sztuczna inteligencja, przetwarzanie ogromnych wolumenów danych przez zaawansowane algorytmy oraz coraz bardziej złożone systemy monitorujące każdego dnia redefiniują realia funkcjonowania współczesnych przedsiębiorstw. Dynamiczny postęp technologiczny okazuje się nie tylko źródłem nieznanych wcześniej możliwości biznesowych, ale też generuje nowe, często złożone wyzwania etyczne i prawne. Akcentowane są dziś przez opinię publiczną oraz regulatorów kwestie transparentności procesów decyzyjnych, poszanowania prywatności użytkowników oraz ograniczenia ryzyka nadużyć dotyczących monitorowania aktywności zarówno konsumentów, jak i pracowników. Firmy technologiczne, funkcjonujące w otoczeniu określonym regulacjami prawnymi, ale i wyraźną presją społeczną, stoją wobec konieczności nieustannego mierzenia się z problematyką etyki w zakresie rozwoju i wdrażania sztucznej inteligencji.

Rosnące znaczenie etyki AI w zarządzaniu danymi i praktykach biznesowych

W ostatnich latach coraz mocniejszy nacisk kładzie się na etyczny wymiar działań firm operujących w sektorze nowoczesnych technologii. Wprowadzenie do powszechnego użytku zaawansowanych algorytmów sztucznej inteligencji umożliwiło gromadzenie i analizowanie danych w sposób, który jeszcze dekadę temu wydawał się wyłącznie domeną literatury science fiction. Taki postęp skutkuje jednak gwałtownym wzrostem oczekiwań społecznych – nie tylko odnośnie skuteczności nowych technologii, ale przede wszystkim ich transparentności oraz bezpieczeństwa. Zjawisko to nie sposób rozpatrywać w oderwaniu od etycznych dylematów związanych z wykorzystywaniem AI do monitorowania zachowań użytkowników, analizy ich preferencji czy predykcyjnych modeli wykorzystywanych w sektorze finansowym czy marketingu.

Firmy stają przed koniecznością wdrożenia jasnych oraz jednoznacznych standardów dotyczących ochrony prywatności i danych osobowych, eliminacji nietransparentnych algorytmów oraz zapobiegania tworzeniu nieuzasadnionych profili użytkowników. Etyka AI oznacza zatem nie tylko zgodność z przepisami prawa, takimi jak ogólne rozporządzenie o ochronie danych osobowych (RODO), lecz także przyjęcie odpowiedzialności za długofalowe skutki wdrożenia algorytmicznych systemów podejmowania decyzji. Kluczowe staje się tu zapewnienie audytowalności procesów, umożliwienie wyjaśnienia, na jakich podstawach algorytm doszedł do pewnego wniosku oraz upowszechnienie praktyk odpowiedzialnego zarządzania zbiorem danych wejściowych, aby uniknąć efektów tak zwanej „czarnej skrzynki”.

Dyskusja o etyce AI coraz częściej wykracza poza mury akademickie i środowiska legislacyjne, stając się fundamentalnym elementem strategii komunikacyjnych oraz polityki wewnętrznej firm. Rosnąca presja ze strony zarówno konsumentów, jak i partnerów biznesowych, skłania przedsiębiorstwa do wdrożenia programów szkoleniowych z zakresu etycznego przetwarzania danych oraz systemów zgodności (compliance) obejmujących AI na wszystkich poziomach działalności. Równocześnie dynamicznie rozwijający się trend tak zwanej „AI explainability”, polegający na umożliwieniu zrozumienia działania algorytmów także przez osoby bez wykształcenia technicznego, sprawia, że transparentność oraz odpowiedzialność stają się kluczowymi elementami przewag konkurencyjnych na rynku wysokich technologii.

Prywatność użytkowników pod presją: korporacyjny monitoring i inwigilacja w erze AI

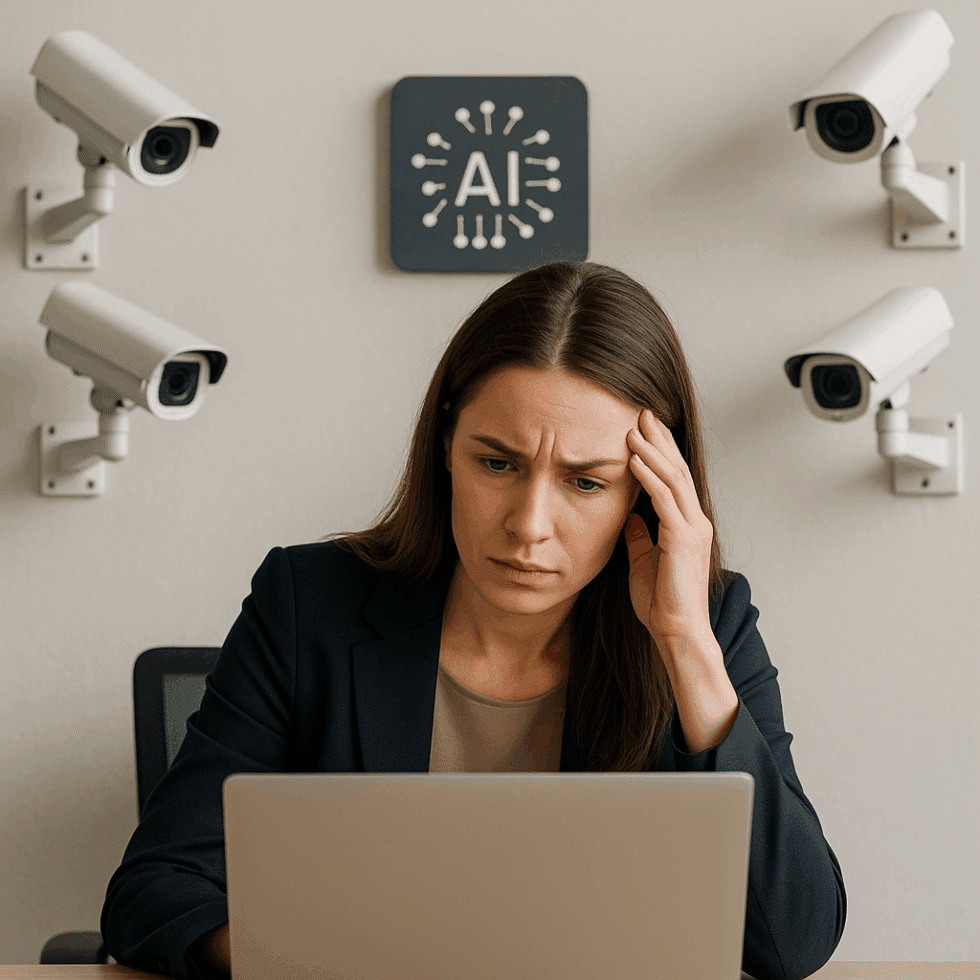

Wprowadzenie narzędzi sztucznej inteligencji do codziennej działalności przedsiębiorstw skutkuje istotnym poszerzeniem zakresu monitoringu oraz nadzoru. W obszarze relacji firma-klient skutkuje to m.in. możliwością śledzenia każdego etapu interakcji użytkownika z daną marką, tworzenia profili behawioralnych na bazie historii przeglądania stron internetowych, analizy ruchu i geolokalizacji, a nawet przewidywania przyszłych decyzji zakupowych w oparciu o dane poddawane analizie predykcyjnej. Podobne narzędzia coraz częściej implementowane są także wewnątrz organizacji – przykładowo do monitorowania aktywności pracowników, oceniania efektywności ich pracy, detekcji potencjalnych zagrożeń związanych z wyciekiem informacji czy nadużyciami finansowymi.

Tak szerokie spektrum zastosowań AI w nadzorze może prowadzić do znacznych naruszeń prywatności, często trudnych do wychwycenia nawet dla samych zainteresowanych. Wyłania się tu fundamentalny problem proporcjonalności – na ile głęboki monitoring jest uzasadniony z perspektywy biznesowej, a w którym momencie zaczyna zagrażać autonomii oraz godności jednostki. W kontekście korporacyjnych programów analizy wydajności czy tzw. employee surveillance coraz większa liczba ekspertów wyraża obawy przed stworzeniem środowisk pracy opartych na ciągłym nadzorze i kontroli, które mogą prowadzić do pogorszenia atmosfery w zespołach oraz naruszeń prawa pracy. Z drugiej strony firmy argumentują, iż zaawansowane modele predykcyjne pozwalają efektywniej zarządzać bezpieczeństwem informacji i zapobiegać oszustwom.

Kontekst ten sprawia, że coraz większe znaczenie ma opracowywanie i wdrażanie spójnych kodeksów postępowania oraz polityk prywatności odnośnie stosowania AI w monitoringu. Przykładowo, transparentne informowanie pracowników oraz klientów o celu i zakresie monitorowania, zapewnienie dostępu do własnych danych oraz możliwości zgłoszenia sprzeciwu czy ograniczenia zakresu zbierania informacji, stają się obowiązującą normą. W wielu jurysdykcjach regulatorzy nakładają na firmy obowiązek przeprowadzania tzw. Data Protection Impact Assessment (DPIA) przed wprowadzeniem nowych rozwiązań AI mających wpływ na sferę prywatności. Odpowiedzialne zbalansowanie interesów biznesowych oraz praw pracowników i użytkowników stanowi dziś nie tylko wymóg prawny, ale coraz częściej warunek utrzymania dobrej reputacji oraz zaufania interesariuszy.

Regulacje prawne a presja opinii publicznej – rola instytucji i społeczeństwa

Ramy prawne dotyczące stosowania sztucznej inteligencji w zakresie monitorowania oraz przetwarzania danych osobowych stają się coraz bardziej wyśrubowane, zarówno na poziomie krajowym, jak i międzynarodowym. Sercem tych regulacji pozostaje Unia Europejska ze swoim rozporządzeniem o ochronie danych osobowych (RODO), które ustanawia surowe standardy dotyczące zbierania, przetwarzania oraz przechowywania danych użytkowników. Coraz częściej jednak słychać głosy, że dynamiczny rozwój AI wyprzedza możliwości legislacyjne, a istniejące przepisy nie nadążają za skalą i złożonością nowych technologii, takich jak machine learning czy deep learning.

Presja regulacyjna idzie jednak w parze z oczekiwaniami społecznymi. Z jednej strony mamy coraz świadomszych cyfrowo konsumentów, domagających się nie tylko bezpieczeństwa własnych danych, ale także prawa do zrozumienia, kiedy i w jakim zakresie poddawani są algorytmicznemu nadzorowi. Z drugiej – rośnie liczba incydentów naruszeń prywatności czy wycieków danych, co prowadzi do realnych strat finansowych dla firm oraz często niepowetowanych szkód wizerunkowych. Reputacja korporacji staje się tu dobrem równie cennym, jak posiadane zasoby cyfrowe, a opinia publiczna ma coraz większy wpływ na kierunek zmian polityki wewnętrznej podmiotów technologicznych.

W odpowiedzi na powyższe wyzwania instytucje nadzorujące oraz regulatorzy coraz częściej wprowadzają obowiązek stosowania tzw. audytów algorytmicznych, mających na celu wykrywanie potencjalnych uprzedzeń i niepożądanych efektów ubocznych modeli AI. Powszechną praktyką staje się również zatrudnianie pełnomocników ds. etyki cyfrowej (ethical officers) oraz tworzenie wewnętrznych rad ds. odpowiedzialnego wdrażania nowych technologii. Przewaga konkurencyjna przesuwa się zatem w kierunku firm nie tylko najbardziej innowacyjnych technologicznie, ale przede wszystkim tych, które potrafią udowodnić odpowiedzialność społeczną oraz spójność działań w zakresie ochrony danych i prywatności.

Odpowiedzialna strategia wdrożenia AI – rekomendacje i perspektywy rozwoju

Biorąc pod uwagę szybki postęp technologiczny oraz coraz wyższe wymagania społeczne i legislacyjne, kluczową rolę odgrywa dziś strategiczne podejście do wdrażania sztucznej inteligencji w firmach technologicznych oraz całym sektorze biznesowym. Odpowiedzialna strategia wdrożenia AI opierać się musi na kilku filarach: po pierwsze, konieczna jest gruntowna analiza ryzyka – zarówno prawnego, jak i reputacyjnego – związanego z implementacją narzędzi opartych na uczeniu maszynowym. Firmy powinny skupić się na diagnozowaniu możliwych ścieżek nadużyć, skutków potencjalnych błędów algorytmicznych oraz niezamierzonych dyskryminacji, jakie mogą powstawać w wyniku nieprawidłowego tworzenia lub trenowania modeli.

Drugim filarem jest transparentność – zarówno na etapie komunikowania użytkownikom i partnerom stosowanych technologii, jak również udostępniania mechanizmów pozwalających na sprawowanie rzeczywistej kontroli nad własnymi danymi. Przejrzystość procesów przetwarzania informacji, możliwość uzyskania jasnych informacji dotyczących zasad podejmowania decyzji przez algorytm oraz możliwość odmowy poddania się algorytmicznemu profilowaniu, to dziś fundamenty budowania zaufania – zarówno wśród klientów, jak i pracowników. Kolejnym nieodzownym krokiem jest inwestycja w rozwój kompetencji cyfrowych kadry zarządzającej oraz działów technicznych, tak aby potrafiły nie tylko projektować innowacyjne systemy, ale również rozumieć ich szerszy kontekst społeczny, prawny i etyczny.

Ostatnim, lecz równie istotnym elementem strategii jest aktywne zaangażowanie się w proces dialogu społecznego i współpracy z instytucjami legislacyjnymi. Firmy technologiczne powinny uczestniczyć w otwartych konsultacjach branżowych, rozwijać współpracę z organizacjami pozarządowymi oraz środowiskami eksperckimi zajmującymi się ochroną praw cyfrowych. Takie podejście nie tylko pozwala przewidywać trendy regulacyjne i z wyprzedzeniem dostosowywać modele biznesowe, ale również realnie wpływa na kształtowanie bardziej responsywnego, etycznego środowiska rozwoju nowych technologii. Wspólna odpowiedzialność za rozwój sztucznej inteligencji, z poszanowaniem praw i wolności jednostki, staje się dziś jednym z kluczowych wyróżników nowoczesnych firm gotowych na wyzwania ery cyfrowej.